AAA2020 可解釋人工智能(XAI) 從理論到實踐的全景透視

近年來,人工智能技術飛速發(fā)展,但在實際應用中,模型的“黑箱”特性成為制約其廣泛應用的關鍵挑戰(zhàn)。AAA2020會議上發(fā)布的230頁PPT,系統(tǒng)性地闡述了可解釋人工智能(XAI)從基礎理論到工業(yè)應用的全過程,為開發(fā)者和研究者提供了重要參考。

XAI的基礎理論部分首先回顧了傳統(tǒng)機器學習模型的可解釋性瓶頸,深入分析了決策樹、線性模型等傳統(tǒng)可解釋方法,并引入深度學習中的注意力機制、對抗樣本解釋、局部可解釋模型(LIME)和SHAP等前沿技術。這些理論不僅涵蓋了模型透明度的數(shù)學原理,還強調了在模型復雜性和可解釋性之間取得平衡的重要性。

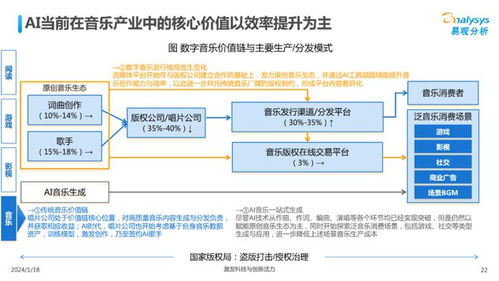

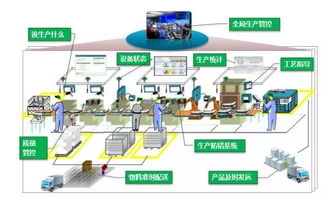

在工業(yè)應用層面,PPT詳細展示了XAI在醫(yī)療診斷、金融風控、自動駕駛和智能制造等領域的實際案例。例如,在醫(yī)療影像分析中,XAI技術能夠可視化模型關注的關鍵區(qū)域,幫助醫(yī)生理解AI的診斷依據(jù);在金融領域,可解釋的信用評分模型提升了監(jiān)管合規(guī)性和用戶信任度。這些應用不僅驗證了XAI技術的實用性,還突顯了其在解決現(xiàn)實問題中的巨大潛力。

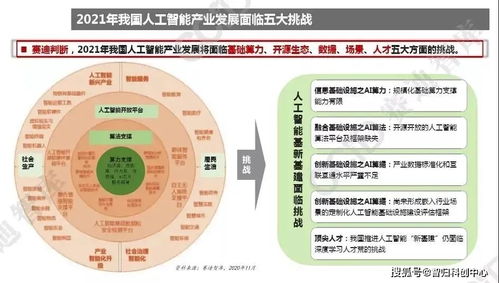

XAI的落地并非一帆風順。PPT中總結了實際挑戰(zhàn),包括模型精度與可解釋性的權衡、計算資源的高消耗、跨領域可解釋標準的缺失,以及用戶對解釋結果的理解差異等。經(jīng)驗教訓部分指出,成功的XAI項目需要多學科團隊協(xié)作,結合領域知識設計解釋方法,并在開發(fā)早期就將可解釋性納入系統(tǒng)設計考量。

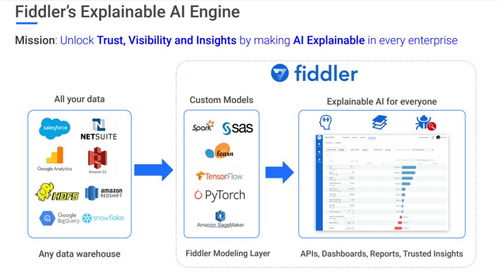

PPT強調了人工智能基礎軟件開發(fā)在推動XAI普及中的關鍵作用。開源工具如TensorFlow Explainability和InterpretML降低了XAI的應用門檻,而企業(yè)級平臺則通過集成可視化界面和自動化解釋生成,進一步提升了開發(fā)效率。未來,隨著法規(guī)對AI透明度的要求日益嚴格,XAI必將在人工智能生態(tài)中扮演更加核心的角色。

AAA2020的這份資料不僅是一份技術指南,更是一張連接理論研究與產業(yè)實踐的路線圖,為構建可信、可靠的人工智能系統(tǒng)提供了堅實基礎。

如若轉載,請注明出處:http://www.mwje.cn/product/25.html

更新時間:2026-01-12 00:03:25